“대규모언어모델(LLM)을 위한 하드웨어는 계산력은 물론 충분한 메모리 용량과 대역폭이 필수입니다. 병목이 심해 모든 계층에서 메모리의 중요성은 더욱 커지고 있습니다. 더 빠른 추론을 위해서는 고대역폭메모리(HBM)와 인공지능(AI) 모델을 분산시킬 상호 연결성을 갖춰야 합니다.”

노암 샤지어 구글 제미나이 AI 프로젝트 공동 리더는 25일(현지 시간) 미 스탠퍼드대에서 열린 ‘핫칩스 2025’ 기조연설자로 나서 “AI의 속도는 매개변수(파라미터)를 얼마나 빠르게 살펴볼 수 있는가에 달려 있으나 현대 반도체는 메모리보다 연산 속도가 더 빠르다”며 “빠른 추론을 원한다면 칩셋 전체의 메모리 대역폭이 중요해진다”고 강조했다.

샤지어는 생성형 AI 시대의 문을 연 구글브레인의 '어텐션 이즈 올 유 니드' 논문 공저자 중 하나다. 노벨 물리학상을 거머쥔 ‘딥러닝의 아버지’ 제프리 힌튼 토론토대 교수와 공동 연구로 오픈AI·딥시크 등이 애용하는 전문가혼합(MoE) 방식을 개발하기도 했다. 샤지어는 이후 캐릭터AI를 창업했으나 지난해 구글이 27억 달러에 달하는 거액에 회사를 인수하며 ‘친정’으로 복귀했다. 최근 메타가 유행시킨 ‘애크하이어(acqui-hire·인수와 고용의 합성어)’ 붐의 시작을 끊은 셈이다.

샤지어는 알고리즘이 아닌 하드웨어가 AI 발전을 가로막는다는 입장이다. 그는 7년 전 연산력·데이터 등이 ‘클수록 좋다’고 주장했던 강연을 회고하며 데이터·매개변수 확장을 제한하는 메모리의 한계가 AI 발전의 장애물이라고 지적했다.

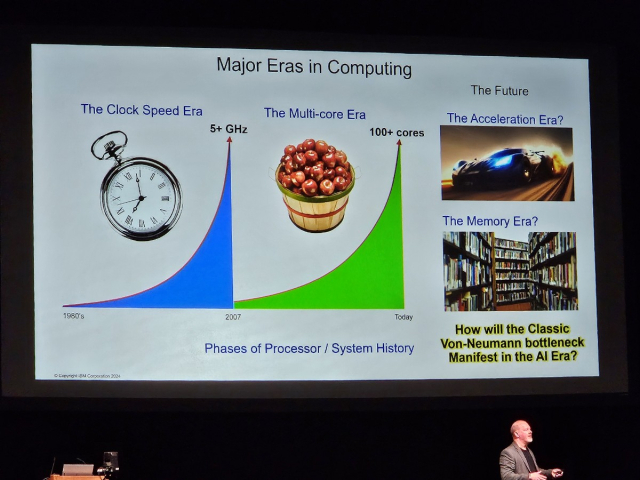

이는 80여년 간 컴퓨터 표준으로 자리잡은 폰노이만 구조가 지닌 근본적 한계 탓이다. 폰노이만 구조는 연산장치·메모리·프로그램을 구분해 하나의 하드웨어로 다양한 소프트웨어를 사용할 수 있다. 하지만 각각이 분리돼 있어 상대적으로 느린 메모리를 통해 프로그램을 읽는 과정에서 병목현상이 일어난다. AI 시대가 열리며 읽어야 할 데이터가 비약적으로 커지며 병목의 문제점이 더욱 도드라지는 것이다.

메모리의 중요성은 기조연설에 앞서 이뤄진 IBM의 발표에서도 강조됐다. IBM은 올 7월 공개한 파워11 중앙처리장치(CPU)에 AI 가속기를 통합하는 한편 일종의 ‘메모리 댐’을 둬 코어 당 메모리 용량과 대역폭을 4배 늘리고 일반 DDR5 D램으로도 HBM에 버금가는 속도를 확보했다. 결과적으로 전세대와 같은 삼성전자(005930) 7㎚ 공정을 사용했음에도 45%의 성능 개선을 이뤘다. 빌 스타크 IBM 파워 프로세서 설계총괄은 “AI 시대를 맞아 전통적인 폰노이만 병목이 확연해졌다”며 “작동 속도를 높이고 코어 수를 늘리는 시대를 지나 가속과 메모리의 시대가 오고 있다”고 강조했다.

![[이상직 변호사의 생성과 소멸] 〈2〉과학기술시대, 생성과 소멸은 무엇인가 (중)](https://img.etnews.com/news/article/2025/08/22/news-p.v1.20250822.c1f6d40e30d04b38815b66154ef9c357_P3.jpg)

![[기고] AI 리터러시 교육이 매우 시급하다](https://img.newspim.com/news/2025/08/06/2508060816449040.jpg)

![[기고] AI거품론, 우리가 놓치고 있는 것](https://img.newspim.com/news/2025/01/06/2501060829105660.jpg)

![[신간] AI가 새로 쓰는 유통의 법칙...'AI 커머스 쇼핑 전쟁'](https://img.newspim.com/news/2025/08/25/2508251012106600.jpg)