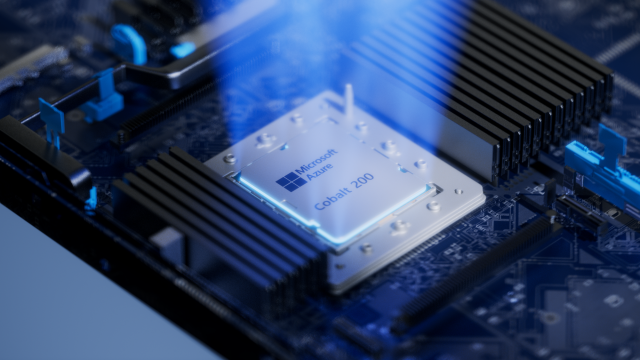

마이크로소프트(MS)가 자체 개발 신형 중앙처리장치(CPU) ‘코발트200’을 공개했다. 공정 미세화와 최적화 설계를 바탕으로 기존 코발트100보다 최대 50% 높은 성능을 낸다. 자체 서비스에 특화한 저전력·고효율 칩셋으로 AI 인프라 구축 부담을 줄이려는 빅테크 행보에 가속도가 붙고 있다는 분석이 따른다.

18일(현지 시간) MS는 미 샌프란시스코에서 열린 연례 기술 컨퍼런스 ‘이그나이트 2025’에서 신형 칩셋 코발트200을 소개했다. 이그나이트 2023에서 전 세대인 코발트100을 선보인지 2년만에 개선판을 내놓은 것이다.

코발트200은 ARM 서버용 CPU 지식재산권(IP)인 네오버스 CSS v3 기반이다. 기존 코발트100이 128개 코어였던 반면 코발트200은 코어가 132개로 소폭 늘었다. 캐시 메모리는 L2는 코어당 3MB(메가바이트), L3는 192MB다. TSMC 5㎚(나노미터)였던 제조 공정은 3㎚로 더욱 미세해졌다.

설계 단에서도 변화가 크다. 모든 코어에 각기 다른 전압과 주파수를 적용할 수 있도록 했다. 필요한 연산량에 따라 전력 소모와 성능을 조절할 수 있는 구조다. 압축·해제·암호화 관련 특화 설계도 더했다. MS는 “관련 작업량이 전체 클라우드 부담의 30% 이상”이라며 “단순한 CPU 코어 선택, 메모리 크기 조정만으로는 한계가 있어 전용 맞춤형 압축·암호화 가속기를 추가했다”고 설명했다.

코발트 시리즈는 설계 단계부터 MS 클라우드 애저에서 가장 많이 요구하는 ‘일반적인’ 작업에 특화해 효율을 높인 CPU다. 오피스, 팀즈 등이 대표적이다. 이에 코발트100은 MS 업무협업툴 팀즈 사용시 타 CPU 대비 최대 45% 높은 성능을 보였다. 코발트200은 전 세대보다 최고 성능이 50%가량 늘어난 만큼 더욱 효율적인 연산 처리가 가능할 전망이다.

MS는 이미 코발트200을 애저에 도입해 내부 이용중이다. 내년부터는 클라우드 내 본격 도입해 외부 서비스에도 나설 계획이다. 2023년 11월 공개된 코발트100이 2024년 상반기부터 의미 있는 수준으로 배치됐던 사례에 미뤄볼 때 코발트200도 내년 상반기 중 본격 활용이 예상된다.

MS를 비롯해 아마존, 구글 등 주요 클라우드 업체는 저전력·저비용 자체 칩셋을 적극 도입 중이다. 아마존은 ‘트레이니엄’, 구글은 TPU를 대량 적용하고 있다. 엔비디아와 AMD AI 가속기 가격 폭등과 수급난 속 AI 인프라 비용을 최소화하기 위함이다. 대형 클라우드는 각사 자체 서비스 수요가 충분해 엔비디아, 인텔 등의 ‘범용’ AI 가속기와 CPU 대신 특수 작업에만 쓰이는 전용 칩셋(ASIC)을 활용할 수 있는 여지도 크다.